Klimawandel - reale Bedrohung oder Hysterie?

1. Prolog

Bibel, Buch Mose, Kap. 1:

„Und Gott segnete sie und sprach zu ihnen: Seid fruchtbar und mehret euch, füllet die Erde und mach sie euch untertan!“

Dies hat der Mensch in den vergangenen Jahrtausenden durchgehend befolgt. Zunächst war es schwierig für ihn, sich auf der Erde zu behaupten, aber mit der Erfindung der Werkzeuge, zunächst aus Stein, dann aus Bronze und schließlich aus Eisen, wurde er Herr über die Erde. Ein weiterer, ganz erheblicher Machtzuwachs wurde ihm jedoch erst zu Beginn des 19. Jahrhunderts zu teil. Mit der Entdeckung der Energie wurde er in den folgenden zweihundert Jahren zum totalen Beherrscher der Welt. 1806 führte der englische Physiker David Young das Kunstwort „energy“ ein, das inzwischen in der ganzen Welt zum Zauberwort geworden ist, wenngleich kaum einer den Begriff Energie korrekt erklären kann, und für viele ist auch heute noch im 21. Jahrhundert Energie und Kraft das gleiche. Einfach ausgedrückt ist Energie die Fähigkeit Arbeit zu leisten. Dabei kann Energie in den verschiedensten Formen (elektrisch, magnetisch, chemisch, thermisch u.a.) vorkommen. Wichtig ist vor allem, dass sie von einer Form in eine oder auch mehrere andere umgewandelt werden kann, wobei die Summe der Energien immer die gleiche bleibt (Satz von der Erhaltung der Energie). So hat die Sonne in den vergangenen Jahrmillionen der Erde elektro-magnetische Energie (Licht) zugestrahlt, das von den Pflanzen in chemische Energie umgewandelt wurde und seitdem in Form von Kohle, Öl oder Gas im Boden gespeichert ist. Dies ist die Energiequelle, die mit Beginn des 19. Jahrhunderts vom Menschen erschlossen wurde und den Siegeszug der industriellen Entwicklung einleitete. Mit ihrer Hilfe konnte sich der moderne Mensch schneller fortbewegen, extreme Lasten befördern, große Bauprojekte in kurzer Zeit vollenden, ertragreiche Ernten einfahren und sich somit gut und ausreichend ernähren, ...

Seit annähernd 200 Jahren werden diese Fossilien dem Boden entnommen und die bei ihrer Verbrennung anfallenden Gase bedenkenlos über immer höhere Schornsteine in die Atmosphäre entlassen. Ebenso wie die Erde erschien den Menschen die Atmosphäre als schier grenzenlos. Zweifel an dieser auch heute noch oft anzutreffenden Auffassung kamen erst in der zweiten Hälfte des 20. Jahrhunderts auf. Namentlich der „Club of Rome“, eine Gruppe von Wissenschaftlern, die sich mit Fragen der Umwelt und den Vorratskapazitäten der Erde befassten, trat ab 1972 mit warnenden Thesen (St. Gallen Symposium: „Die Grenzen des Wachstums“) an die Öffentlichkeit. Sie erregten auch eine Zeitlang Aufmerksamkeit, aber dann erlosch das Interesse an diesen kritischen Themen wieder. Es gab wichtigere Fragen im Leben der Normalbürger: die atomare Bedrohung, der Zusammenbruch des Sowjet-Imperiums oder auch Finanzkrisen und dergleichen.

Heute sehen wir die Dinge wiederum aus einer anderen Perspektive. Die klimatischen Veränderungen sind inzwischen jedem augenfällig: Es schmelzen die Gletscher in den Alpen und an den Polen, die Orkane und Tornados werden heftiger und zahlreicher, und es wird allenthalben wärmer. Inzwischen fragt sich auch so mancher: „wie konnten wir nur so dumm sein, und unsere empfindliche Atmosphäre als Endlager für all die Abgase benutzen? Hätten wir die Kohle, das Öl und das Erdgas doch nur dort belassen, wo sie seit Jahrmillionen sicher aufbewahrt waren, tief im Boden der Erde“. Ja, aber dann hätten wir natürlich auch auf die Vorteile verzichten müssen, die uns die fossile Energie beschert hat. Wie auch immer, es ist geschehen, der Geist ist aus der Flasche, und er wird von alleine wohl auch nicht dahinein zurückkehren. Dabei ist die Atmosphäre für alle Menschen und Tiere von grundlegender Bedeutung. Sie schützt uns vor der aggressiven UV-Strahlung der Sonne, und noch bedeutsamer, sie versorgt uns mit dem lebensnotwendigen Sauerstoff.

Vielleicht ist aber die Klage über den schlechten Zustand der Atmosphäre auch nur eine Übertreibung von einigen Wissenschaftlern und ihren Apologeten, die sich wichtig machen wollen, wer weiß das schon? Nun, als Physiker sollte ich da eigentlich schon etwas Profunderes dazu sagen können, auch wenn die Atmosphärenphysik nicht mein Fachgebiet ist. Ich habe mir deshalb einige Zeit genommen und mich in die Thematik eingearbeitet – kein einfaches Unterfangen. Vor allem gibt es ein überbordendes Angebot an Publikationen, Büchern und Berichten. Allein die Vielzahl der Texte, die alljährlich vom Internationalen Klimarat, dem IPCC (Intergovernmental Panel on Climate Change, www.ipcc.ch) in der Form von Reports, Assessments und Empfehlungen an Politikern herausgegeben werden, ist riesig *) . Da muss man sich beschränken. In meinem heutigen Vortrag werde ich versuchen, ihnen einige grundlegende Dinge zu vermitteln, die meines Erachtens zur Beurteilung der Problematik unabdingbar sind.

*) Bei meinen Recherchen habe ich mich im Wesentlichen auf zwei Standardwerke gestützt:

[1] Walter Roedel und Thomas Wagner, Physik unserer Umwelt: Die Atmosphäre, Springer-Spektrum Verlag

[2] John H. Seinfeld und Spyros N. Pandis, Atmospheric Chemistry and Physics – From Air Pollution to Climate

Change, Wiley

2. Die Erdatmosphäre

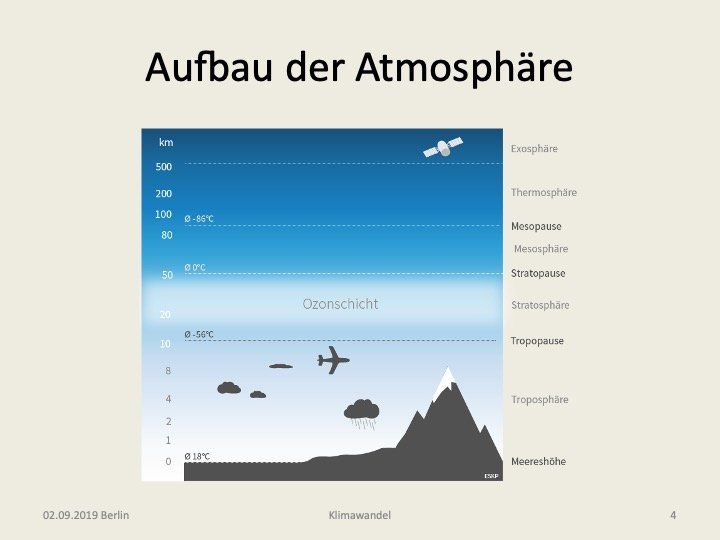

Die Abb. 1

illustriert den Aufbau der Atmosphäre. Sie gliedert sich vom Boden nach oben gehend in fünf Bereiche:

- Troposphäre (0-10 km),

- Stratosphäre (10-50 km),

- Mesosphäre (50-90 km),

- Thermosphäre (90-500 km)

- Exosphäre (> 500 km) .

Es handelt sich dabei um eine Unterteilung nach Gebieten in denen die Temperatur mit zunehmender Höhe entweder fällt (Troposphäre, Mesosphäre, Exosphäre) oder ansteigt (Stratosphäre, Thermosphäre). In den Übergangsgebieten ist die Temperatur über Bereiche von etwa 10 km näherungsweise konstant. Jedem Übergangsgebiet von einem Bereich in den darüber liegenden wird das Suffix „Pause“ angehängt, also Tropopause, Stratopause usw. Für das Folgende können wir uns weitgehend auf die beiden untersten Bereiche, die Troposphäre und Stratosphäre, beschränken. Die Höhenabhängigkeit von Luftdruck (p) , Teilchenzahldichte (n) und Temperatur (T) sind in der Abb. 2

dargestellt *1). Die zuvor angesprochenen Besonderheiten des Temperaturverlauf kann man dem rechten Bild entnehmen. Hier weisen beide Achsen (T, z) eine lineare Skala auf *2). Ausgehend von der mittleren Jahrestemperatur von 15°C = 288 K auf Meereshöhe (z = 0) fällt diese auf den ersten Höhenkilometern linear mit -6°C/km ab, erreicht dann aber in der Tropopause (z =10 bis 20 km) ihren Tiefstwert von 217 K = - 56 °C. Ursache für diese (adiabatische) Abkühlung ist die Arbeit, die das Gas gegen die Schwerkraft leisten muss, wenn es in die Höhe steigt. Diese Energie wird der Bewegungsenergie der Teilchen entzogen, was sich in einer Temperaturerniedrigung bemerkbar macht. Oberhalb der Tropopause steigt die Temperatur dann wieder an, was nun auf die Strahlungsheizung durch die Sonneneinstrahlung zurück zu führen ist. In der Stratopause, d.h. einer Höhe von etwa 50 km wird dann ein relatives Temperaturmaximum mit T = 271 K = -2°C erreicht. Die Höhenabhängigkeit von Druck und Teilchendichte ist in der linken Abbildung wiedergegeben. Hier wurde für die horizontale Achse, auf der die normierten Größen p/p0 und n/n0 aufgetragen sind, eine logarithmische Skala gewählt, da dann eine Exponentialverteilung der Art f(z) = exp(-z/H) zur Geraden wird. Wie man sieht, ist das für den Druck (blaue Punkte) in sehr guter Näherung der Fall. Für die Teilchendichte (orange), die ja der Quotient von Druck und Temperatur ist, gilt das wegen des S-förmigen Verlaufs der Temperatur nur noch in eingeschränktem Maße. Interessanterweise ist die charakteristische Skalenhöhe H = 7,4 km für alle in der Atmosphäre vorkommenden Teilchensorten die gleiche, was zunächst sehr verwunderlich ist, da ansonsten – wie zum Beispiel im Falle von Sedimenten – die Regel gilt: die schwereren Teilchen konzentrieren sich am Boden. Grund für diese Besonderheit ist der turbulente Transport, der bis zu einer Höhe von etwa 70 km für eine starke Durchmischung der Atmosphäre sorgt. Dies hat auch zur Folge, dass beispielsweise die mittlere Verweildauer der Teilchen in der Troposphäre nur einige Wochen beträgt.

Wie wir der linken Abbildung entnehmen können, hat eine Skalenhöhe von 7,4 km zur Folge, dass die Teilchendichte in einer Höhe von 70 km auf 1/10 000 des Wertes am Boden abgefallen ist. Die Skalenhöhe H = 7,4 km ist im Übrigen auch diejenige Höhe, die man für die Atmosphäre erhalten würde, wenn die Dichte nicht mir steigenden Höhe abnehmen, sondern konstant bliebe. Das verdeutlicht uns den Umstand, dass die gesamte Atmosphäre eigentlich eine hauchdünne Schicht ist, die die Erde einhüllt, denn das Verhältnis von H zum Erdradius (R = 6300 km) beläuft sich auf lediglich H/R ≈ 0,1 %.

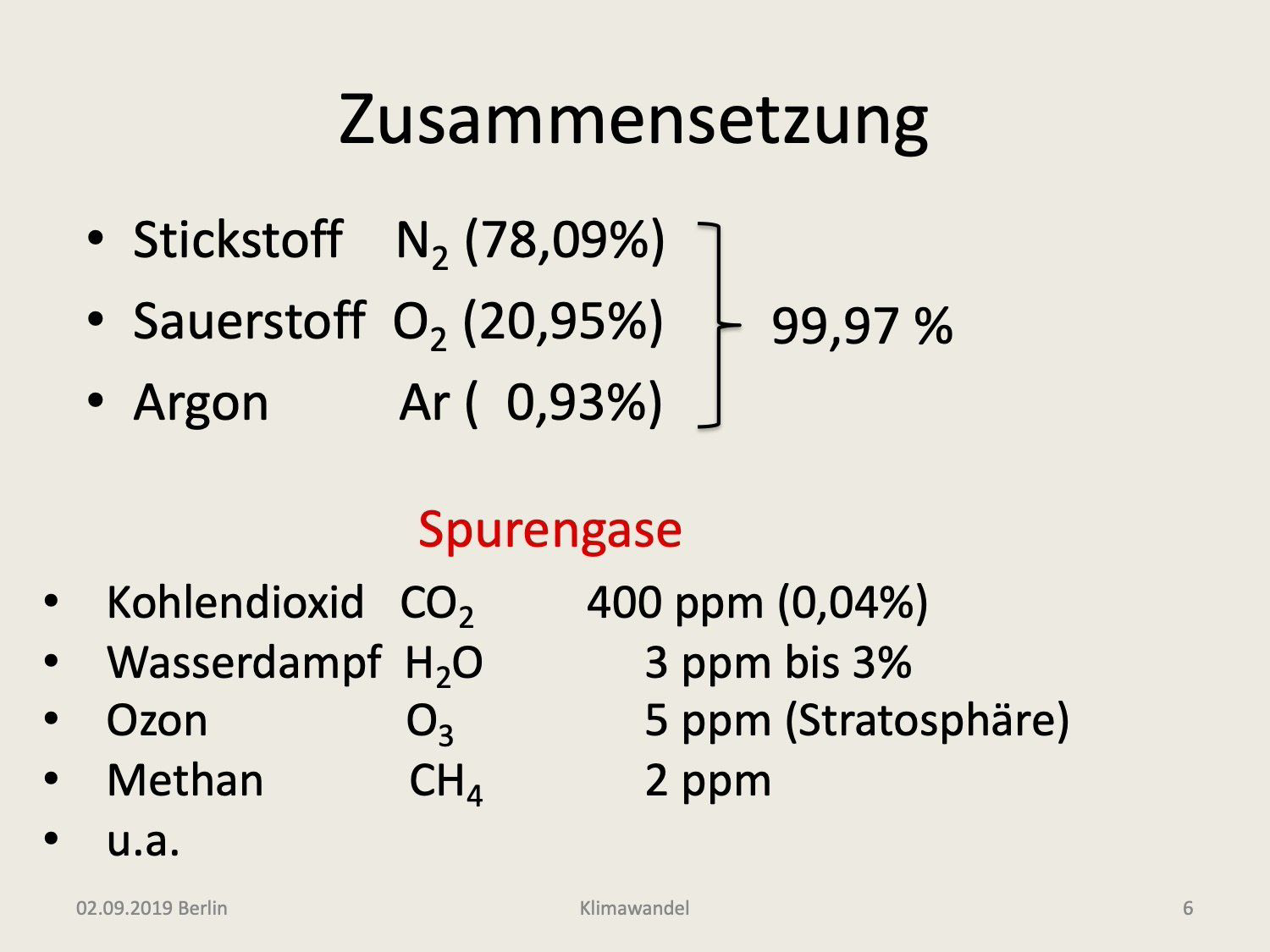

In der Abb. 3

sind nun die wichtigsten Teilchensorten aufgeführt, die in der Atmosphäre vorkommen. Da stehen zunächst die Gasmoleküle von Stickstoff und Sauerstoff, die zusammen schon 99% ausmachen, gefolgt von dem Edelgas Argon mit etwa 0,9%. Man kann es durchaus als eine glückliche Fügung ansehen, dass diese drei Gase 99,97% aller Teilchen abdecken, denn es handelt sich um Teilchen, die im infraroten Teil des Spektrums praktisch keine Aktivität entfalten, was der Erde die Möglichkeit lässt, ein Großteil der von der Sonne aufgenommenen Strahlung wieder bei einer gemäßigten Oberflächentemperatur von 288 K in den Weltraum abzustrahlen. Bei den Molekülen verdanken wir das dem Umstand, dass Stickstoff und Sauerstoff homonukleare Verbindungen in der Form von N2 und O2 eingehen, die kein elektrisches Dipolmoment aufweisen. Bei den Edelgasen andererseits und somit auch beim Argon liegen die niedrigsten Anregungsniveaus so hoch über dem Grundzustand, dass sie nur hochenergetisches UV-Licht absorbieren können.

Es verbleiben daher nur die Spurengase, die trotz ihrer sehr geringen Konzentrationen, von großer klimatischer Bedeutung sind. Einige dieser Gase sind in der Abb. 3

aufgeführt. An erster Stelle steht dort das Kohlendioxid, das bei jedem Verbrennungsprozess freigesetzt wird. Es ist inzwischen mit einer Konzentration von 400 ppm in der Atmosphäre vorhanden *4). Wasserdampf wird in der öffentlichen Diskussion zwar kaum erwähnt, ist aber nichts desto weniger von fast gleicher Bedeutung für das Klima. Hier sind in erster Linie die freien H2O Moleküle gemeint, weniger das in den Wolken kondensierte Wasser. Im Gegensatz zu den übrigen Spurengasen unterliegt der Wasserdampf starken Konzentrationsschwankungen. Während in der Stratosphäre und der oberen Troposphäre niedrige Konzentrationen von etwa 3ppm typisch sind, findet man in der unteren Troposphäre Gebiete, wo die Konzentration auf bis zu 3% ansteigen kann. Insgesamt ist der Einfluss des Wasserdampfes in der Atmosphäre und ebenso der Wolken noch unzureichend verstanden.

3. Die Energiebilanz der Erde

Wie strahlen warme Körper?

Für das Verständnis der Energiebilanz ist die von Max Planck im Jahre 1900 abgeleitete Strahlungsformel (Abb. 4) von herausragender Bedeutung. Hierbei beschreibt die Funktion B(T) die von einem „schwarzen Körper“ bei der Temperatur T abgestrahlte Leistung als Funktion der Wellenlänge (λ). Die Bezeichnung schwarzer Körper bezieht sich dabei auf metallene Hohlzylinder, wie sie gegen Ende des 19. Jahrhunderts insbesondere von dem Berliner Physiker Heinrich Rubens verwendet wurden, um deren Strahlungsverhalten im Infraroten zu messen. Der Hohlzylinder wurde hierbei an einem Ende vollständig verschlossen, während man am anderen Ende eine kleine Kreisfläche offen ließ. Solange der Zylinder kalt ist, bildete die Öffnung ein tief schwarzes Loch aus dem praktisch kein Licht heraus kommt. Wird der Zylinder aber dann durch eine ihn umschlingende Heizwicklung aufgeheizt, so wird diese Öffnung zu einer intensiven Strahlungsquelle. Zunächst, bei niedrigen Temperaturen, strahlt die Öffnung fast ausschließlich unsichtbares Infrarotlicht, dann aber bei höheren Temperaturen von etwa 500°C und darüber zunehmend auch sichtbares Licht aus. Interessanterweise strahlen derartige schwarze Körper deutlich intensiver als alle sonstigen Körper bei gleicher Temperatur. Letztere nennt man „graue Strahler“ und die von ihnen abgegebene Strahlungsintensität charakterisiert man durch das sogenannte Emissionsvermögen ε, wobei ε eine Zahl zwischen 0 und 1 ist. Planck hatte die oben angegebene Formel zunächst nur empirisch durch Vergleich mit den Messdaten von Rubens abgeleitet. Der Versuch sie auch physikalisch zu deuten bereitete jedoch die größten Schwierigkeiten. Planck sah sich schließlich genötigt, für den Energieaustausch eine Beschränkung einzuführen, indem er den hierbei beteiligten Lichtteilchen (Photonen) eine von der Wellenlänge abhängige Energie h c/λ zuwies, wobei c die Lichtgeschwindigkeit und h das in der Ausgangsformel (Abb. 4) ebenfalls vorkommende Plancksche-Wirkungsquantum ist. Damit war der Anfang für eine neue Physik, die Quantenphysik, vorgegeben, die in den kommenden Jahrzehnten bis in die Jetztzeit unser Weltbild und ebenso die technische Entwicklung (man denke an Transistoren, Laser, LED-Leuchten und letztlich auch Computer) revolutionieren sollte.

In der Abb. 4 sehen wir auch die Intensitätsverteilungen für drei unterschiedliche Temperaturen, die mit der angegeben Formel berechnet wurden. Die Wellenlänge ist hier in Einheiten von Mikrometern (μm) angeben. Das Maximum der grünen Kurve mit T = 6000 K, was in guter Näherung der Oberflächentemperatur unserer Sonne entspricht, liegt dann bei einer Wellenlänge von 0,5 μm, was grünes Licht ist. Wie man sieht, verschiebt sich das Maximum mit abnehmender Temperatur zu größeren Wellenlängen und liegt für T < 3500 K bereits außerhalb des sichtbaren Bereichs im Infraroten. Dieser Sachverhalt war schon vor 1900 empirisch gefunden worden und ist als Wiensches Verschiebungsgesetz bekannt . Setzen wir in diese Beziehung die mittlere Oberflächentemperatur der Erde T = 288K ein, so erhalten wir für die Wellenlänge 10 μm. Das ist also der entscheidende Infrarotbereich, wo die Abkühlung der Erde stattfindet. Mit Hilfe der Integralrechnung können wir nun anhand der Planckfunktion auch die über den gesamten Wellenlängenbereich abgestrahlte Leistung P berechnen. Sie ist durch den Flächeninhalt unter der Kurve gekennzeichnet und steigt mit der vierten Potenz der Temperatur an (P = σ T^4, s. Abb. 4). Diese Relation war ebenfalls schon vor 1900 aus thermodynamischen Analysen hervorgegangen und ist als Stefan-Boltzmann-Gesetz (SBG) bekannt.

Wie konstant strahlt die Sonne?

Gelegentlich stößt man auf die Vermutung, dass das Klimaproblem von der Sonne ausgehe, da diese einfach eine schwankende Energiequelle sei. Dazu wurden in den vergangenen Jahrzehnten sehr präzise Langzeitmessungen mit Satelliten in der Exosphäre vorgenommen. Der gemessene Zeitverlauf der jahresgemittelten Solarkonstante S ist in der Abb. 5

wiedergegeben ([1], S. 20). Wie man der oberen Kurve entnehmen kann, lag diese gemittelte Strahlungsleistung der Sonne während der Zeitspanne 1978 bis 2016 immer im Bereich von 1360 bis 1361 W/m^2. Die Schwankung beträgt also weniger als 0,1% und ist damit zu gering, um klimatisch von Relevanz zu sein. Interessanterweise korrelieren die verbleibenden Schwankungen sehr schön mit der 11-jährigen Periode der Sonnenaktivität, die sich in der Zahl der Sonnenflecken offenbart. In der Abb. 5

sind der unteren Kurve die Zyklen 21 bis 24 der Sonnenfleckenhäufigkeit zugeordnet.

Strahlungsbilanz der Erde

Wenn am Rand der Atmosphäre eine Strahlungsleistungsdichte von S = 1360 W/m2 vorliegt, dann beträgt die der Erde ständig zufließende Sonnenleistung L = π R^2 S, wobei π R^2 die kreisförmige Querschnittsfläche der Erde ist. Verteilen wir diese Leistung über die viermal größere Oberfläche der Erde, so ergibt sich eine mittlere Eingangs-Leistungsdichte von Pein = S/4 = 340 W/m^2. Die gleiche Leistung muss aber auch ständig wieder von der Erde in den Weltraum abfließen, wenn die Erde thermisch im Gleichgewicht ist, d.h. sich weder aufheizt noch abkühlt. Es muss also gelten Pein = Paus. Von den eingehenden 340 W/m^2 können wir sogleich den Bruchteil abziehen der als sogenannte Albedo (A) wieder in Form von sichtbarer Strahlung reflektiert wird. Das sind bei der Erde 30%. Der verbleibende Rest von 70% wird dagegen als Infrarotstrahlung im Wellenlängenbereich bei 10 μm in den Weltraum abgestrahlt und wir erhalten P = S (1-A)/4 = 238 W/m^2. Diese einfache Bilanz ist in der Abb. 6 noch einmal veranschaulicht (wobei dort noch ein älterer Wert von S = 1368 W/m^2 zugrunde gelegt wurde).

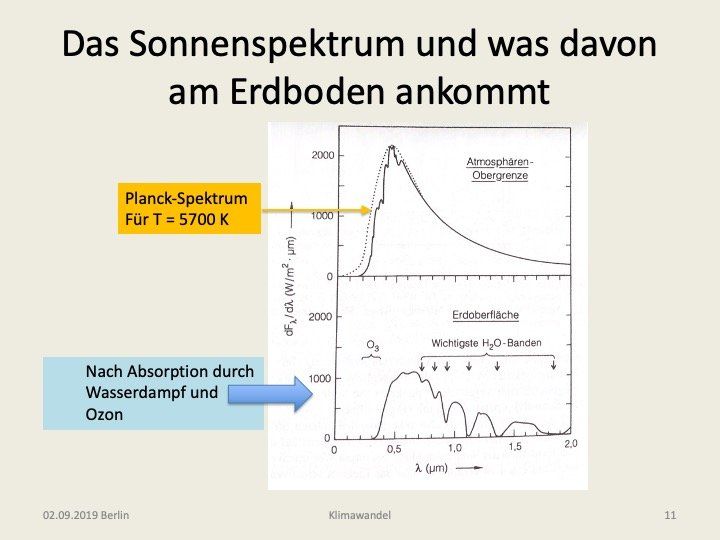

In der Abb. 7 sehen wir nun im oberen Teil die gemessene Spektralverteilung des Sonnenlichtes am Rand der Atmosphäre und im unteren, was davon am Erdboden ankommt [1, S. 26]. Zunächst bestätigt das obere, dass die Planckfunktion unter der Annahme einer Sonnenoberflächentemperatur von T = 5700 K recht gut die Messung beschreibt. Im unteren Bild sehen wir den verbleibenden Anteil am Boden für den Fall, dass die Sonnenstrahlung unter einem Winkel von 30° zum Horizont einfällt. Der UV-Anteil unterhalb von 0,4 Mikrometern ist infolge Absorption durch Ozonmoleküle stark reduziert und der nahe Infrarotbereich (0,8 bis 2 μm) weist starke Einbrüche aufgrund von Absorption an Wassermolekülen auf.

Diese, teils in der Stratosphäre vor allem aber in der Troposphäre ablaufenden Prozesse sind im linken Teil der Abb. 8

erläutert. Hierbei ist zu unterscheiden zwischen Streuung und Absorption. Bei einem Absorptionsprozess wird jeweils ein Photon vom Molekül bzw. Atom „verschluckt“ und seine Energie in Wärme umgewandelt (Heizung der Atmosphäre), während bei der Streuung lediglich seine Richtung geändert wird. Bezogen auf die ursprüngliche Richtung des Lichtstrahls führen beide Prozesse zu einer Abnahme der Intensität (Extinktion), aber im Fall der Streuung kann die Strahlungsenergie auch in die entgegengesetzte Richtung gelenkt werden (Rückstreuung in den Weltraum). Dem Schaubild entnehmen wir, dass die Albedo von 30% sich aus drei Streuanteilen zusammensetzt, wobei die Streuung an den Wolken den Hauptanteil von 17% ausmacht, während die Rückstreuung am Boden lediglich mit 7% hieran beteiligt ist. Letztlich kommen am Boden nur 47% (160 W/m^2) der Eingangsleistung an. Zusammen mit den 23%, die der Atmosphäre infolge der Absorptionsprozesse zukommen, ergeben diese beiden Energieflüsse die Leistung von 70% die in Infrarotstrahlung umgewandelt werden muss.

Im rechten Teil der Abbildung wird nun auf eine wichtige Diskrepanz hingewiesen. Versucht man nämlich die erforderliche Infrarotstrahlung aus der mittleren Oberflächentemperatur von TE = 288 K mit Hilfe des Stefan-Boltzmann Gesetzes zu erklären, so stellt man fest, dass dazu dem Boden ein Energiezufluss von 395 W/m^2 zugehen müsste, während dort in Wirklichkeit nur 160 W/m^2 ankommen. Schlimmer noch, diese 395 W/m^2 stehen ja noch nicht einmal am Rand der Atmosphäre zur Verfügung, da selbst dort nur 340 W/m^2 eingehen. Diese Diskrepanz findet ihre Erklärung, wenn wir den Treibhauseffekt der Spurengase in unsere Betrachtungen einbeziehen, was wir im übernächsten Abschnitt tun werden.

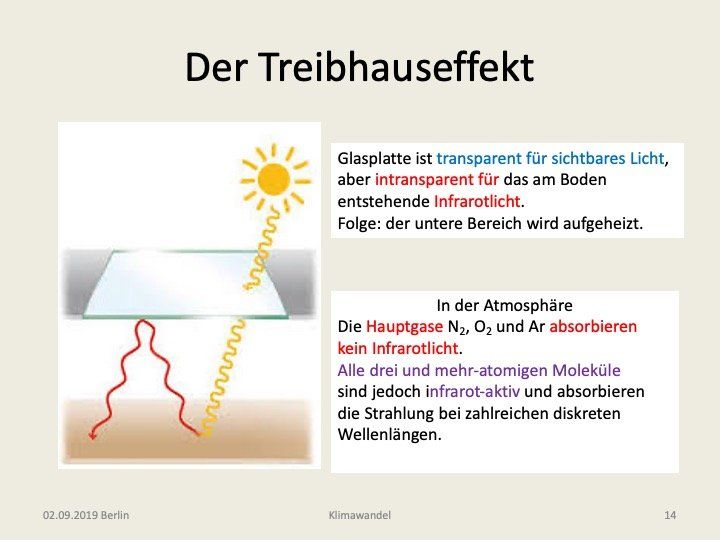

Der Treibhauseffekt

Das grundlegende Prinzip des Treibhauseffektes verdeutlicht die Abb. 9. Das von der Sonne ausgehende sichtbare Licht durchdringt eine Glasplatte und wird am Boden absorbiert. Die hiermit verbundene Energieaufnahme führt zu einer Erwärmung des Bodens, so dass dieser Strahlung im Infrarotbereich emittiert. Glas ist jedoch für Infrarotlicht intransparent, so dass die emittierte Strahlung wieder zur Erde zurückgestreut wird. Es kommt so zu einer Aufheizung im unteren Bereich, die solange anhält bis die infolge der höheren Temperatur zunehmenden Wärmeverluste (z.B. durch Wärmeleitung der Wände) ein neues Gleichgewicht etablieren.

In der Atmosphäre passiert etwas Ähnliches. Hier ist es wichtig, dass die drei Hauptgase Stickstoff, Sauerstoff und Argon kein Infrarotlicht absorbieren, wohl aber alle Spurengase. Das zeigt die Abb. 10

([1], S. 46). Im oberen Teil der Abbildung (10a) sehen wir dort die Planckfunktion für eine Bodentemperatur von T = 288K aufgetragen über den Wellenlängenbereich 0 bis 30 μm. In der Mitte (10b) ist sodann das von der Atmosphäre zur Erde zurückgestrahlte Licht – die sogenannte Gegenstrahlung – zu sehen. Diese weist zwei Maxima auf, bei 7 und 13 μm. Das erste ist auf die Gegenstrahlung der Wassermoleküle, das zweite auf diejenige der CO2-Moleküle zurückzuführen. Auch oberhalb von 20 μm ist wiederum die Strahlung der H2O-Moleküle sehr intensiv. Daneben ist auch Ozon mit einem weniger bedeutsamen Strahlungspeak bei 9,6 μm vertreten. Nicht in Erscheinung treten in der Abbildung schwächere Absorptionsbanden der Moleküle Methan und Distickstoffoxid (Lachgas). Im unteren Teil der Abbildung (10c) sehen wir nun das, was an Infrarotlicht bei wolkenlosem Himmel in den Weltraum abgestrahlt wird (c = a-b). Es ist im Wesentlichen auf den Fensterbereich 7,5 bis 13 μm beschränkt. Steigt nun etwa die CO2-Molekülkonzentration weiter an, so wird dieser Fensterbereich an seiner rechten Seite weiter beschnitten und die abgestrahlte Leistung geht zunächst zurück. In der Folge steigt aber die Temperatur in der Nähe der Erdoberfläche weiter an, und zwar solange, bis nun die proportional zu T^4 ansteigende Infrarotintensität im Bereich des verkleinerten Fensterbereichs wieder die eingehende Strahlungsleistung kompensiert. Außerhalb des Fensterbereiches ist die atmosphärische Gegenstrahlung bereits fast gleich stark wie die Bodenstrahlung, so dass die nach außen abgestrahlte Leistung nahezu null ist. Eine weitere Steigerung der Treibhausgas-Konzentrationen ist damit in diesem Wellenlängenbereich fast folgenlos. Dieser Sättigungseffekt führt zu einer günstigen Abschwächung der Treibhauseffizienz.

Auch die Höhe der Schicht aus der die Gegenstrahlung erfolgt ist von Bedeutung. Je höher diese innerhalb der Troposphäre liegt, um so geringer ist ihre Temperatur (s. Abb. 5) und damit die zu T^4 proportionale Gegenstrahlung. Im Gegensatz hierzu sind tief liegende Wolken- oder Wasserdampfschichten besonders klimaeffektiv, da sie einen starken Treibhauseffekt auslösen. Diese Erfahrung kann leicht jeder machen: Ist der Himmel wolkenlos, kann es trotz kräftiger Sonne recht kühl sein, ziehen dann aber Wolken auf, wird es wärmer.

Auflösung der Diskrepanz

Zum Abschluss dieser Erörterung der Treibhausmechanismen wenden wir uns noch einmal der im Zusammenhang mit

Abb. 9 besprochenen Diskrepanz zu. Hierzu betrachten wir nun in der

Abb. 11

eine teilabsorbierende Schicht (grauer Strahler, ε < 1) in noch unbekannter Höhe (s. auch [2], S. 938-939). Der grüne Pfeil versinnbildlicht die den Boden erreichende Strahlungsnettoleistung im Sichtbaren, der wir sogleich (vermöge SBG) eine fiktive Bodentemperatur von zuordnen. Dies wäre die mittlere Oberflächentemperatur der Erde ohne Atmosphäre nach Maßgabe des Stefan-Boltzmannschen Gesetzes Tin= (Pin/σ)^1/4 = 255 K. In ähnlicher Weise wollen wir den gelb gezeichneten Infrarotflüssen, die vom Boden (Pg) und der absorbierenden Schicht (Pa) ausgehen, Temperaturen zuordnen: Tg = (Pg/σ)^1/4 und Ta = (Pa/σ)^1/4. Die Schicht emittiert die Leistung Pa einerseits als Gegenstrahlung zur Erde hin und ebenso an ihrer Oberseite in den Weltraum. Zusätzlich kommt hier noch der transparente Anteil der Grundstrahlung Pg(1-ε) hinzu. Nun betrachten wir die Strahlungsbilanzen am oberen Atmosphärenrand Pin =Pa + Pg (1-ε) und am Boden Pin + Pa =Pg. Sie haben die Lösungen

Tg= Tin (2/(2-ε))^(1/4) und Ta =Tin (ε/(2-ε))^(1/4)

Setzen wir in die erste für die Bodentemperatur Tg = 288 K ein, so sehen wir, dass wegen Tin= 255 K dies nur mit ε = 0,78 zu erreichen ist. Für die Temperatur der Schicht folgt dann Ta= 227 K. Aus der Abb. 2

entnehmen wir sodann, dass die Schicht in einer Höhe von 9 km liegen muss. Teilen wir die beiden oben abgeleiteten Ausdrücke für die Temperaturen durcheinander, so folgt ganz allgemein

Tg/Ta =(2/ε)^(1/4) ≥ 1,19

Die Bodentemperatur ist damit immer um mindestens 19% höher als die Temperatur der absorbierenden Schicht. Obwohl die vorausgehende Behandlung der Strahlungsbilanz eine relativ starke Vereinfachung des Problems darstellt, macht sie doch eins sehr deutlich: Eine mittlere Oberflächentemperatur der Erde von 288 K ist nur erreichbar, wenn die Atmosphäre in der Lage ist, einen erheblichen Teil der von der Erde ausgehenden Infrarotstrahlung zu absorbieren und als Gegenstrahlung zurückzustrahlen. Mit anderen Worten: ohne Treibhausgase läge die Erdtemperatur um 288-255 = 33 K niedriger und die Erde wäre damit unter einem Eispanzer begraben.

Radiative Forcing und Temperaturanstieg

Im Folgenden wollen wir noch einen Begriff erläutern, der bei der quantitativen Beurteilung der Klimaproblematik eine Rolle spielt. So dient das Radiative Forcing

(RF) als Maßzahl für die Stärke einer Störung der Strahlungsbilanz (s. Abb. 12). Sie wird in W/m^2 angegeben. Von besonderem Interesse sind in diesem Zusammenhang diejenigen Störungen, die infolge der Konzentrationsänderungen eines Treibhausgases zwischen vorindustriellen Zeiten und der Jetztzeit oder einer in der näheren Zukunft zu erwartenden Konzentration verbunden sind. In der Abb. 12

ist speziell der Fall des radiative forcing mit Bezug auf eine Verdopplung der CO2-Konzentration im Vergleich zum vorindustriellen Wert von 280 ppm behandelt. Hier lautet die Frage: um welchen Wert müsste man die Netto-Eingangsleistung am Rand der Atmosphäre erhöhen, um die gleiche Temperaturerhöhung am Boden zu erreichen, wenn die Konzentration von 280 ppm auf 560 ppm ansteigt? Die numerischen Simulationen ergaben RF = 3,7 W/m^2, d.h. anstelle von Pin= 238 W/m^2 müssten es 241,7 W/m^2 sein.

Es stellt sich nun die tiefergehende Frage: was für eine Änderung des Klimas ergibt sich daraus langfristig? Charakteristische Klimadaten sind beispielsweise die jährliche Niederschlagsmenge aber vor allem die globale Jahrestemperatur. Lassen wir zunächst die Langzeitwirkungen außer acht, so können wir die Temperaturerhöhung wieder aus dem Stefan-Boltzmann-Gesetz T = (P/σ)^(1/4) ableiten. Differentiation von T nach P führt auf

dT/T = 1/4 dP/P und somit für den Temperaturanstieg dT = (288/4) (3,7/238) = 1,2 °C

Unter Berücksichtigung der Trägheit der Ozeane und anderer Langzeitfaktoren, wie das Abschmelzen von Eisschichten (Änderung der Albedo) und die Freisetzung von CO2 aus den Permafrostböden, ergeben sich jedoch deutlich höhere Werte. So prognostizierte der Internationale Klimarat IPCC im Jahre 2013 Temperaturanstiege im Bereich von dT = 1,5 – 4,5 °C. Die aktuelle Prognose liegt bei einem etwas moderateren Anstieg von 3 °C im Zeitraum von einigen Jahrzehnten.

4. CO2 in der Atmosphäre

CO2-Quellen und Senken

Für Kohlendioxid gibt es drei Hauptreservoire: Die Ozeane, die Landflächen und die Atmosphäre. Zwischen diesen Reservoiren werden ständig Teilchen ausgetauscht, wie das in der

Abb. 13

veranschaulicht ist. Von jedem der drei Eckpunkte des Dreiecks gehen Teilchenflüsse zu den beiden benachbarten. Es hat sich jedoch herausgestellt, dass eine derartige „3-Kammer-Analyse“ mit 6 kommunizierenden Flüssen nicht ausreichend ist, um die Wirklichkeit hinreichend genau zu beschreiben. Eine weitere Verfeinerung ist in der

Abb. 14

dargestellt. Hierbei werden Land und Ozean in jeweils zwei weitere Zonen unterteilt, die nach oben mit der Atmosphäre in Kontakt stehen und nach unten durch die Fossilienschicht und eine kalte Tiefenschicht der Ozeane ergänzt werden. Während die Fossilienschicht eine reine Teilchenquelle darstellt, die nur vom Menschen bedient und von der das CO2 direkt in die Atmosphäre befördert wird, hat die kalte Tiefenschicht der Ozeane noch natürlichen Austausch mit den darüber liegenden warmen und kalten Oberschichten. Der Abfluss zu der am tiefsten liegen Sedimentschicht, der letztlich die einzige Möglichkeit bietet, das CO2 wieder dauerhaft aus dem Gesamtkreislauf zu entfernen, ist jedoch leider sehr gering. Die Aufteilung des Landes in Biosphäre (Pflanzen, Wald) und Bodenschicht (Gras, Moore, Permafrostböden u.ä.) erscheint zunächst etwas willkürlich, ist aber dennoch sinnvoll, da die Verweildauern in den jeweiligen Reservoiren sehr unterschiedlich sind. Ein derartiges verkoppeltes System, bestehend aus 7 Reservoiren und 9 Flüssen, hat R. A. Schmitz 2002 ausgehend vom vorindustriellen Gleichgewichtszustand bis zum Jahr 2000 zeitlich nachverfolgt*4).

Der Kohlenstoff-Kreislauf

Der stationäre Kreislaufprozess des CO2 ist sehr schön in der Abb. 15

für das Jahr 2006 veranschaulicht. Hierin sind die Inventare (in Gigatonnen C) in den einzelnen Reservoiren als fett gedruckte Zahlen angegeben *5). Die entsprechenden Flüsse werden durch gerichtete Pfeile mit Zahlenangaben (Gt C/Jahr) in Normalschrift gekennzeichnet. Die mittleren Verweildauern der CO2-Moleküle in jedem Reservoir sind in Klammern gesetzt. Wir sehen zunächst, dass die Inventare in der Atmosphäre (800 Gt), in der etwa 100 m dicken Ozeanoberschicht (900 Gt) sowie in der Biosphäre (560 Gt) und in den Böden (1500 Gt) vergleichbar sind. Deutlich größere Mengen befinden sich jedoch in den ozeanischen Tiefenschichten (37 000 Gt) und in den fossilen Lagerstätten (Kohle + Öl + Gas, 6000 Gt). Die mit Abstand größten Mengen (30 Mill. Gt) befinden in den marinen Sedimentschichten. Dort ist der Kohlenstoff in Form von Carbonaten (Calcit, Dolomit u.a.) gespeichert. Wie schon erwähnt, ist der Zufluss zu diesem Bereich aber mit 0,1 Gt/a sehr klein. An der Oberfläche der Ozeane fließt diesen – vornehmlich in den äquatorfernen Zonen – aus der Atmosphäre pro Jahr 92 Gt zu. Gleichzeitig geben die Ozeane jedoch auch – in der Äquatorzone – 90 Gt Kohlenstoff pro Jahr an die Atmosphäre ab. Die Ozeane sind also global betrachtet eine CO2 Senke. Allerdings reichen die hierin pro Jahr aufgenommenen 2 Gt C nicht aus, um den anthropogenen Zufluss aus der Verbrennung von Fossilien zu decken. Dieser betrug 2006 noch 6 Gt C pro Jahr ist aber seitdem auf 10,9 Gt/a C = 40 Gt/a CO2 im Jahre 2019 angestiegen. Wichtig sind hier die Pflanzen, die auf dem Wege der Photosynthese CO2 in O2 und Glucose (Traubenzucker) verwandeln *6). Dazu brauchen sie allerdings Wasser und vor allem das Sonnenlicht als Energiequelle, denn das CO2-Molekül ist ein sehr stabiles Molekül, das ohne äußere Energiezufuhr keine chemische Reaktion mit einem anderen Molekül eingeht. Deshalb produzieren die Pflanzen während der Nacht keinen Sauerstoff, vielmehr benötigen sie dann, wie alle anderen Lebewesen, ebenfalls Sauerstoff aus der Luft für ihre Zellatmung bei der sie CO2 ausstoßen. Daher stammen die 60 Gt C, die sie nach Abb. 15

an die Atmosphäre abgeben. Anderseits nehmen sie insgesamt 122 Gt C aus der Atmosphäre auf. Rechnet man aber die 60 Gt C hinzu die vom Boden abgegeben werden und die zusätzliche 1 Gt C infolge von Waldbränden und sonstiger Nettozerstörung der Vegetation, so verbleibt nur 1 Gt C, die der Atmosphäre an Land entzogen werden. In Summa verbleiben von den 6 Gt C, die vom Menschen pro Jahr zusätzlich freigesetzt werden, 3 in der Atmosphäre, 2 werden von den Ozeanen aufgenommen und 1 Gt wird an Land letztlich in Biomasse (Holz) verwandelt. Das war die Bilanz für 2006. Die aktuelle Bilanz dürfte noch schlechter ausfallen.

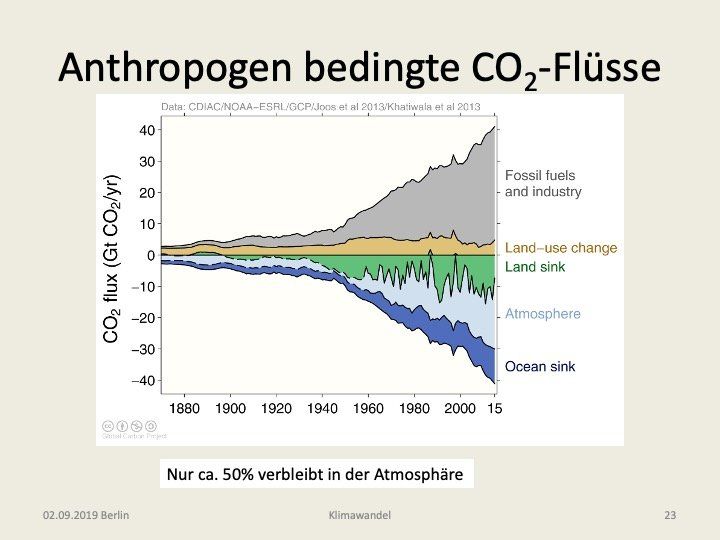

Anthropogen bedingte CO2-Flüsse

Mit Beginn des Industriezeitalters (etwa 1800) setzt eine vom Menschen verursachte Freisetzung von CO2 in die Atmosphäre ein. Wie man der Abb. 16

entnehmen kann, steigt diese ab 1960 steil an und beläuft sich z.Z. auf insgesamt etwa 40 Gigatonnen CO2 pro Jahr. Der Hauptanteil stammt dabei aus fossilen Quellen (Kohle, Öl, Gas). Zu einem kleineren Teil ist auch die intensive Landnutzung hieran beteiligt. Im unteren Teil der Abbildung ist gezeigt, wie sich die Gesamtmenge auf die drei Reservoire: Biomasse (Land sink), Atmosphäre und Ozeane verteilt.

Wie schon im vorigen Abschnitt erläutert, verbleibt etwa die Hälfte des CO2 in der Atmosphäre, die zweite Hälfte verteilt sich zu etwa gleichen Teilen auf die Ozeane und die Pflanzen an Land. Die Aufnahme des CO2 in den Ozeanen ist zwar eine willkommene Entlastung der Atmosphäre, sie ist jedoch auch nicht unproblematisch. Das CO2 verwandelt sich im Wasser nämlich in Kohlensäure (H2CO3) und führt zu einer Versauerung der Meere mit großen Nachteilen für die dortige Tier- und Pflanzenwelt.

Die an Land durch die Bäume aufgenommene Menge wird zu einem erheblichen Teil in Holz umgewandelt. Stirbt ein Baum nach etwa 50 Jahren, so stellt sich die Frage: was macht man mit dem Holz? Verbrennt man es dann, so geht sein CO2-Gehalt direkt wieder in die Atmosphäre zurück, man hat also nur eine Zwischenlagerung von 50 Jahren bewirkt. Ähnliches passiert im Falle der Verrottung, was einer sehr langsamen Verbrennung gleichkommt. Macht man aus dem Holz Möbel, so werden auch diese nicht auf ewig Bestand haben und spätestens nach einigen hundert Jahren wieder als CO2-Gas in die Atmosphäre zurückkehren. Man erkennt, die Vorgehensweise der Natur: Umwandlung in Fossilien und Lagerung in tiefen Bodenschichten, ist nicht die schlechteste Methode, die Menge dieses problematischen Gases im Kreislauf zu begrenzen.

Was sagen die Messungen?

Wertvolle Informationen über die atmosphärischen Konzentrationen in der Vergangenheit enthalten die Eis-Bohrkerne, die man in Grönland und in der Antarktis in den letzten Jahrzehnten aus dem Gletschereis herausgebohrt hat. Diese bis zu 3600 Meter langen Eisstangen enthalten zahlreiche Gasblasen in denen die Zusammensetzung der Atmosphäre in den verschiedensten erdgeschichtlichen Epochen gleichsam eingefroren ist. Insbesondere die antarktischen Kerne erlauben eine Rückschau auf die vergangenen 650 000 Jahre. Erstaunlicherweise hat die CO2-Konzentration während dieser langen Phase den Wert von 300 ppm niemals überschritten

*7). Ein Beleg für die Klimarelevanz des CO2 ist auch der Befund, dass während der Eiszeiten die Konzentration auf 180 ppm absank und damit deutlich niedriger als während der Warmzeiten war.

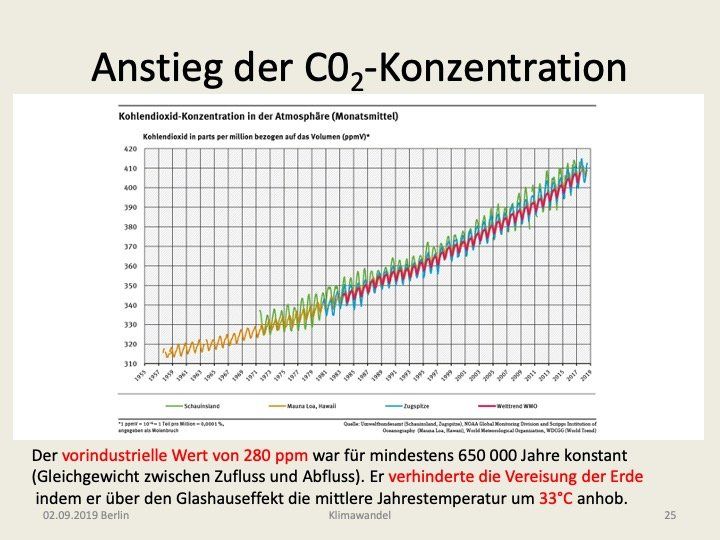

Anstieg der CO2 Konzentration

Systematische Messungen der CO2-Konzentration in der Atmosphäre werden seit 1959 auf Hawaii (Mauna Loa Observatory *8)) durchgeführt. Inzwischen liegen auch Messungen von anderen Beobachtungsstationen vor. In der Abb. 17 sind die Messdaten von insgesamt vier Stationen in Überlagerung dargestellt. Sie belegen einen eindeutigen Anstieg der Konzentrationen ausgehend von 315 ppm im Jahre 1958 bis zu 405 ppm im Jahre 2019. Auffallend sind auch die jährlichen Schwankungen mit einer Amplitude von etwa 3 ppm um den Mittelwert. Die CO2 Konzentration vermindert sich während der Sommerzeit auf der nördlichen Halbkugel um etwa 1,5 ppm aufgrund der pflanzlichen Photosynthese. Diese Variation erklärt sich aus der größeren Landmasse auf der nördlichen Hemisphäre.

Insgesamt wurden seit Beginn der Industrialisierung etwa 2300 Gt CO2 vom Menschen durch Verbrennung fossiler Energieträger freigesetzt, wovon etwa 40% in der Atmosphäre verblieben *9).

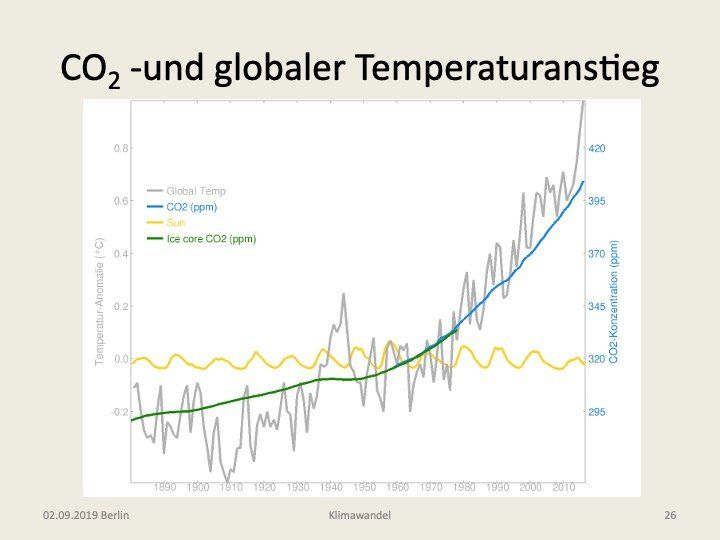

Globaler Temperaturanstieg

Häufig hört man, die globale Temperatur sei in den letzten zwei Jahrzenten nicht weiter angestiegen. Die Messungen sagen jedoch etwas anderes. In der Abb. 18

sehen wir die Messkurve der mittleren Jahrestemperatur, die durch Mittelung über 40 000 Messpunkte auf der gesamten Erde erhalten wurde. In der Zeitspanne von 1900 bis 2015 ist danach die Temperatur um 1,0°C angestiegen. In der Abbildung ist zum Vergleich auch die parallel ansteigende CO2 Konzentration eingetragen (und die nahezu konstante Sonnenleistung). Im Falle der Temperatur muss darauf hingewiesen werden, dass es zwar sehr schwierig ist, absolute Temperaturen an verschiedenen Orten mit einer Genauigkeit von etwa 0,1°C zu messen, Temperaturänderungen am gleichen Ort dagegen sind wesentlich unproblematischer mit dieser Genauigkeit zuverlässig nachzuweisen.

5. Zusammenfassung

Fakten

Die Spurengase CO2, H2O, CH4 u.a. haben, trotz ihrer geringen Konzentrationen, über den Treibhauseffekt einen erheblichen Einfluss auf das Klima. Die vom Menschen in den letzten 100 Jahren in die Atmosphäre eingebrachten Mengen haben bereits eine Temperaturerhöhung von 1°C bewirkt.

Vor allem die durch Verbrennung der fossilen Vorräte bedingte Freisetzung von CO2 hat zu einem 45% Anstieg der Konzentration in der Atmosphäre gegenüber dem vorindustriellen Wert geführt. Eine Fortsetzung der Emissionen auf dem derzeitigen Stand – oder sogar ein weiterer Anstieg – stellt eine ernsthafte Bedrohung für die gesamte Menschheit dar.

Offene Fragen

Die hiermit einhergehenden längerfristigen Temperaturerhöhungen sind quantitativ jedoch schwierig zu erfassen, da die Rückwirkungen aus den Ozeanen, der Biosphäre und den Böden nur unzureichend bekannt sind. Auch der Einfluss der Wolken und der Aerosole ist erst ansatzweise verstanden.

Schließlich gibt es bislang auch keine zufriedenstellende Antwort auf die Schlüsselfrage: „Wie können wir überhaupt zu einem stabilen, stationären Kreislauf des CO2 zurückkehren“? Die Forderung nach einer total CO2-freien Energieproduktion ist zwar leicht erhoben, aber mit den z.Z. vorhandenen Technologien kaum umsetzbar. Die alternativen Wind- und Fotovoltaik- Energien sind zwar prinzipiell dazu in der Lage, haben aber zwei entscheidende Nachteile: 1) hoher Landschaftsverbrauch, 2) stark schwankende Energieproduktion. Den ersten Punkt betreffend ist zu beachten, dass mit zunehmender Weltbevölkerung der Flächenbedarf für die Ernährung ebenfalls stark ansteigen wird und zudem geeignete Standorte schon jetzt rar sind. Die schwankende Energieproduktion beinhaltet die Gefahr eines großflächigen black-out und erfordert eine Energiespeicherung in bisher kaum vorstellbarem Umfang. Damit ist absehbar, dass Wind und Fotovoltaik auch künftig sehr teure Energien bleiben werden. Kernenergie, die andere CO2-freie Alternative, wird zwar in einigen Ländern auch nach den schweren Unglücken in Tschernobyl und Fukoshima weiterhin als Energiequelle in Betracht gezogen, hat aber in Deutschland aus politischen Gründen keine Zukunft. Eine Hoffnung liegt auf der Kernfusion, die die Möglichkeit in Aussicht stellt, sichere Energie zu erschwinglichen Preisen verfügbar zu machen. Hier wird man aber noch einige Jahrzehnte warten müssen, um beurteilen zu können, ob dies tatsächlich die erhoffte Lösung darstellt.

Persönliche Einschätzungen

- Von größter Bedeutung erscheint die Kontrolle der Bevölkerungsexplosion. Im Okt. 2018 lebten auf dem Globus 7,63 Milliarden Menschen. Bei dem derzeitigen jährlichen Zuwachs von 78 Millionen (1,0%) wäre dann im Jahr 2050 mit einer Weltbevölkerung von 10,5 Milliarden (+37%) zu rechnen.

- Die Verbrennung der fossilen Ressourcen darf keinesfalls unvermindert fortgesetzt werden. Diese Vorräte beinhalten etwa das 6-fache der aktuell in der Atmosphäre gespeicherten CO2 Menge und könnten zu einem irreversiblen Kollaps führen (d.h. letztlich Verdampfung der Ozeane, wie auf der Venus vermutlich geschehen), wenn sie vollständig in die Atmosphäre gelangen würden. Der verschwenderische Pro-Kopf-Verbrauch von Energie in einer Vielzahl von Ländern (USA, Kanada, Australien, EU, Russland, u.a.) sollte durch gesetzliche Maßnahmen (CO2-Steuer oder ähnliche Maßnahmen) eingedämmt werden. Auch der die Atmosphäre besonders belastende Flugverkehr ist einzuschränken.

- Bei der Reduzierung des Verbrauchs von Kohle, Gas und Öl muss jedoch auch mit Bedacht vorgegangen werden. Ein totaler Verzicht auf die Nutzung dieser Energieformen schon ab 2030 – wie zur Zeit in Deutschland in der politischen Diskussion – erscheint wirtschaftlich höchst riskant und würde zudem keine Lösung des globalen Problems bedeuten, da wohl kaum ein anderes Land die finanziellen Mittel aufbringen kann, um den gleichen Schritt zu gehen. Da Deutschland an der weltweiten Freisetzung von CO2 mit nur 2% beteiligt ist, hätte es aber – außer einem internationalen Achtungserfolg – auch keine sonderliche Bedeutung, wenn Deutschland die total kohlenstoff-freie Energieproduktion verwirklichen könnte.

- Es erscheint daher sinnvoll, sich in Deutschland – zumindest vorläufig – auf die Stilllegung der Braunkohleförderung zu beschränken, während die noch vorhandenen Kohle- Gas- und auch Kernkraftwerke weiter betrieben werden sollten, um eine sichere Energieversorgung zu gewährleisten.

- Die Möglichkeit der Sequestrierung, d.h. der Abtrennung des CO2 bei der Verbrennung der Fossilien in den Kraftwerken und Unterbringung in unterirdischen Lagerstätten, sollte verstärkt geprüft werden. Eine Abtrennung der Spurengase aus der Atmosphäre (negative Emissionen) erscheint dagegen in hohem Grade unwirtschaftlich wegen der extrem geringen Konzentrationen.

- Eine effektive weltweite Reduktion der relevanten Klimagase in der näheren Zukunft erscheint nach dem Stand der Dinge eher nicht erreichbar. Um dem – mit einem weiteren Temperaturanstieg auf 2° oder sogar 3°C – zu erwartenden Anstieg des Meeresspiegels zu begegnen, sollte eine Erhöhung der Deiche in Betracht gezogen werden.

- Die Pflege der Wälder und eine intensive Bekämpfung der Waldbrände sollte allen Völkern und der internationalen Politik ein großes Anliegen sein, da namentlich die großen Laubbäume mit Hilfe der Photosynthese-Reaktion in der Lage sind, Kohlendioxid sehr effektiv in Sauerstoff und Kohlenwasserstoffe umzuwandeln.

Anmerkungen

*1) Der Druck ist das Produkt von Teilchendichte und Temperatur p = n k T wobei k die Boltzmann-Konstante ist.

*2)

Wir beziehen uns hier auf Internationale Standard Atmosphäre (ISA). Temperaturen werden in der absoluten Einheit Kelvin (K) angegeben, wobei 0 K = -273 °C entspricht. Temperaturdifferenzen haben aber in beiden Systemen (Celsius und Kelvin) den gleichen Wert (z.B. beträgt die Differenz zwischen Siede- und Gefrierpunkt des Wassers 100 °C oder auch 100 K).

*3) ppm = parts per million = 10^-6 oder auch ppb= parts per billion = 10-9 sind übliche Maßzahlen für die Teilchenkonzentrationen im Volumen.

*4)

Schmitz R. A. (2002), The earth carbon cycle, Chem. Eng. Educ. 296. (s. auch [2] S. 916 -918).

*5)

1 Gigatonne = 1 Gt = 1 Milliarden Tonnen = 10^12 kg. Das ist als Wassermenge ein Würfel mit 1 km Kantenlänge. Es sind zwei verschiedene Mengenangaben üblich Gt (C) oder Gt (CO2). Da die Molekülmassen für Kohlenstoff mC = 12 und Kohlendioxid mCO2 = 44 betragen, gilt 1Gt (C) = 44/12 Gt (CO2)= 3,67 Gt (CO2)

*6)

Der vereinfachte Prozess der Photosynthese hat die Darstellung 6CO2 + 6H2O –> C6H12O6 + 6O2

*7)

Gavin Schmidt: 650,000 years of greenhouse gas concentrations. RealClimate.org, 2005.

*8)

Scripps.ucsd.edu

*9)

1 ppm entspricht einer Masse von 7,13 Gt CO2. Die Differenz von (405-280) ppm ergibt dann 891 Gt oder einen Anstieg um 891/2300 = 0,39